Sollten Personen den Weg wählen, Inhalte manuell aus dem Browser zu kopieren und in ChatGPT einzufügen, stehen die Möglichkeiten einer Unterbindung leider schlecht.

Die Server von OpenAI zeigen sich jedoch transparent, indem sie sich korrekt identifizieren. Aus diesem Grund können wir mit einem der beiden folgenden Varianten den Zugriff steuern.

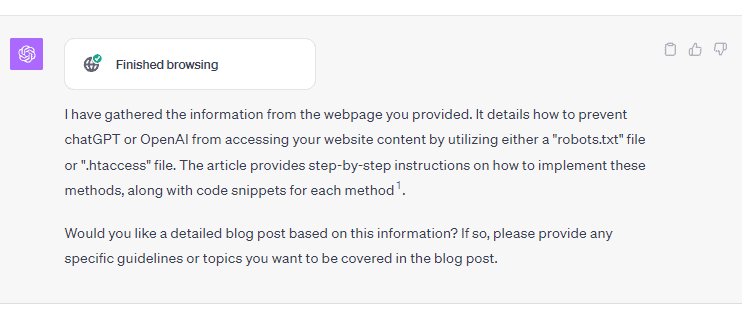

Der Benutzer erhält bei der Benutzung folgende Meldung von ChatGPT:

Zugriff für ChatGPT per robots.txt sperren

Eine weit verbreitete Praxis, um den Zugriff auf die Inhalte Ihrer Webseite zu kontrollieren, ist die Nutzung einer Datei mit dem Namen "robots.txt". In dieser Datei können Anweisungen hinterlegt werden, welche Bereiche Ihrer Webseite von Suchmaschinen und anderen automatischen Diensten nicht gescannt oder indiziert werden sollen.

Um den Zugriff spezieller Bots zu unterbinden, besteht die Möglichkeit, bestimmte User-Agents wie "ChatGPT" oder "OpenAI" hinzuzufügen.

User-agent: ChatGPT

Disallow: /

User-agent: OpenAI

Disallow: /Wie eine solche Datei erstellt werden kann, finden Sie hier. Aber auch diverse SEO-Plugins übernehmen dies bereits und man muss lediglich die Anweisungen ergänzen.

Zugriff für ChatGPT per .htaccess sperren

Der Zugriff von ChatGPT auf Ihre Webseite kann auch per .htaccess unterbunden werden, indem der nachfolgende Code in die ".htaccess"-Datei auf Ihrem Webserver eingefügt wird.

# Blockiert ChatGPT und OpenAI

RewriteEngine on

RewriteCond %{HTTP_USER_AGENT} ChatGPT [OR]

RewriteCond %{HTTP_USER_AGENT} OpenAI

RewriteRule .* - [F]Durch diesen Code wird das mod_rewrite-Modul von Apache genutzt, um den HTTP_USER_AGENT-Header eingehender Anfragen zu prüfen, und sämtliche Anfragen von ChatGPT oder OpenAI mit einer 403-Forbidden-Meldung zurückgewiesen. Wie Sie so etwas auf Ihrem Server konfigurieren können, finden Sie in dieser ausführlichen Anleitung.

Wir bevorzugen diese Methode, da hierdurch tatsächlich eine "Forbidden"-Meldung vom Webserver generiert wird. Im Gegensatz dazu muss ein Bot den Anweisungen in der robots.txt-Datei nicht zwingend folgen, weshalb die .htaccess-Variante eine zuverlässigere Lösung darstellt.

Benötigen Sie Unterstützung?

Sofern Sie von Robots.txt oder .htaccess noch nichts gehört haben, sollten Sie die Implementierung einem Profi überlassen. Kontaktieren Sie uns gerne, falls Sie Hilfe benötigen.

Was ist mit den anderen KI-Tools?

Anders als bei OpenAI scheint zum Beispiel Google Bard keinen expliziten UserAgent mitzuschicken. Es ist anzunehmen das Google hier auf den internen Suchindex zugreift und nicht explizit Webseiten crawled. Sofern wir hier mehr Informationen finden, werden wir das ergänzen.

Fazit

Das Feld der Künstlichen Intelligenz (KI) hält für Blogger zahlreiche Überraschungen bereit, sowohl positive als auch negative. Wir werden zunächst den Blog nicht direkt absichern. Doch für diejenigen, die eine strikte Haltung gegenüber KI einnehmen, besteht die Möglichkeit, den Zugriff des OpenAI-Tools mithilfe der zuvor besprochenen Methoden zu blockieren.